總有些事情你不願再提,或有些人你不願再見。因為那些事或那些人,帶來的傷害你不想再被提起,更不想讓它們被翻出來討論。這就像有些資料,你絕對不想上傳到雲端,被別人看見,哪怕只是意外的可能。我懂,這些事有它的重量,也有它的價值。用本地的 LLM,其實就像給自己建了一座牢固的保險庫,所有的秘密都鎖在裡面,別人再也沒有機會碰觸。你儘管放心,無論是不可見的傷痕,還是那些需要深埋的資料,這一切,只有你能掌控。

以上文字改編自東邪西毒電影台詞。

60 秒看懂本篇文章

本地 LLM 模型

「本地 LLM 模型」指的是在自己電腦或伺服器上運行的大型語言模型。這讓我們可以在不依賴雲端服務的情況下,直接在本地環境中執行 AI 任務,確保資料隱私並降低延遲。

詞源

隨著 AI 技術的進步,許多開源的 LLM 模型被開發出來,讓開發者能夠在本地環境中部署和運行,滿足特定需求。

可以這樣理解

想像你有一台高性能電腦,透過在本地部署 LLM 模型,你可以在不連接網路的情況下,進行自然語言處理、文本生成等操作,完全掌控自己的資料和運算資源。

本地 LLM 模型的核心優勢

- 資料隱私:所有處理都在本地進行,確保敏感資訊不會外流。

- 低延遲:由於不需要透過網路傳輸資料,處理速度更快。

- 高可控性:可以根據需求自訂模型和環境設定,靈活度高。

順便學英文

“Running LLM models locally ensures data privacy and reduces latency.”

在本地運行大型語言模型可確保資料隱私並降低延遲。

本地跑 LLM 模型基礎說明

Ollama 是什麼?

Ollama 就像是一個超方便的管理員,專門幫你在自己的電腦上運行那些很厲害的大型語言模型(像 AI 聊天機器人那樣的東西)。但跟一般需要上網登入的chatGPT 不一樣,Ollama 是設計給本地運行用的,也就是說,你可以完全在自己的電腦上跑這些模型,所有資料都不會被傳到網路上,安全又私密。

Ollama 支援很多不同的開源模型,比如 Llama 3、Phi 3、Mistral,還能在 macOS、Linux 和 Windows 上用。所以,不管你用什麼系統,只要電腦夠強,Ollama 都能幫你在本地跑起來,讓你用自己的 AI 工具。

Open Web UI 是什麼?

想像一下,Open Web UI 就像是一個超直覺的網頁工具,讓你可以輕鬆跟一個超聰明的 AI 模型聊天或測試它的能力。而且它是離線運作的,也就是說,你不需要把任何資料傳到網路上,一切都可以在你自己的電腦裡完成。這對於那些不想把隱私洩露出去的人來說,超級安全。

簡單講,你不用寫什麼指令,就可以讓你和下載回來的模型互動。

舉個例子,假設你下載了一個 AI 模型,但不知道怎麼用它。Open Web UI 就是幫你處理這一切的平台,你只要點幾下滑鼠、輸入問題,它就會幫你跟 AI 模型互動,非常方便。

Docker 是什麼?

你有一個程式,它需要一堆工具或特定的環境來運作,但這些工具可能在不同的電腦上很難設定,或者版本不相容。Docker 就能把這個程式和它所需要的所有工具(像作業系統、程式庫等)打包成一個「容器」。

這個容器就像一個獨立的小空間,裡面什麼都有,讓你的程式可以不受外部環境影響正常運行。這個容器很輕、很方便,拿到哪裡都可以用,在 Windows、macOS 或 Linux 系統上都能跑得很好。

舉例:如果你想運行 Open Web UI,Docker 就幫你把所有技術細節(像伺服器環境、模型檔案等)都包裝好。你不需要手動安裝複雜的依賴程式,也不用擔心你的電腦系統是否符合要求,只要能運行 Docker 容器,就能讓 Open Web UI 順利工作(還是希望電腦效能越高越好啦)。

本地跑 LLM 模型前置需求

- Ollama 安裝

- 下載並安裝 Ollama 工具,詳情參考官方文件:Ollama 官方網站

- Docker 安裝

- 下載並安裝 Docker 工具,詳情參考官方文件:Docker 官方網站 。

- 硬體需求

- 以下步驟僅供Mac使用者參考。

- 強烈建議有一張支持 CUDA 的 GPU(如 NVIDIA 顯卡),以加速模型推理。

- 最好是用Apple M系列處理器。

本地跑 LLM 模型步驟教學

這個教學將指導你阿嬤如何利用 Docker 運行 Ollama 的大型語言模型,並利用 Open Web UI 與電腦本機中的模型進行互動,適合初學者或有本地部署需求的人。

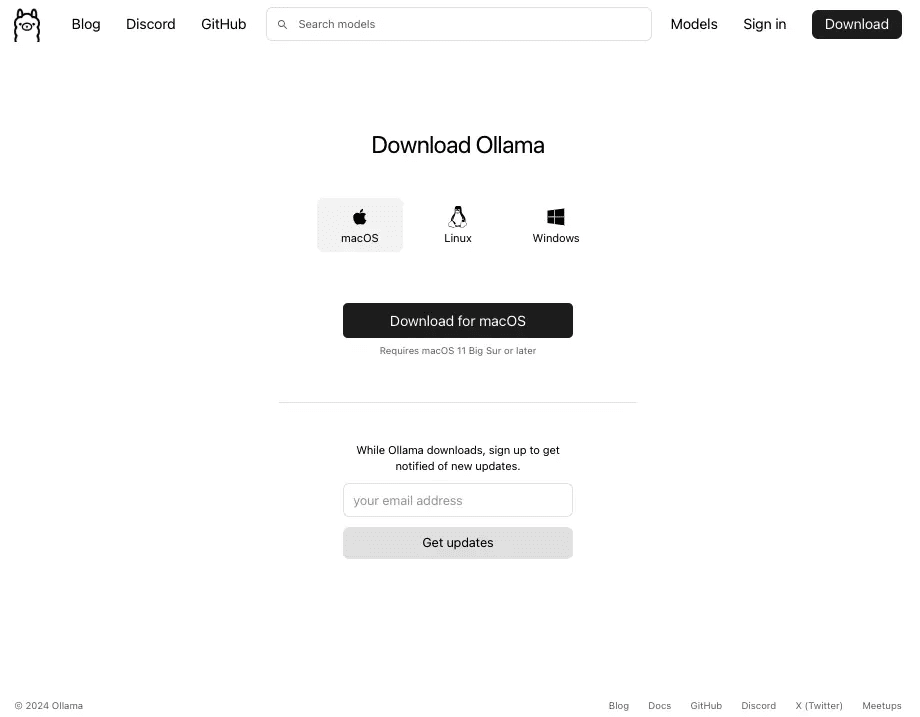

第一步驟:下載 Ollama

Ollama 官方下載頁面,提供 macOS、Linux 和 Windows 的下載選項,我選擇的是 macOS 版本,點擊 ‘Download for macOS’ 按鈕即可,下載完成後再安裝,但你安裝完成之後,點擊 Ollama 應該不會有任何反應,因為它要靠 Docker 來啟動。

第二步驟:下載 Docker

Docker 官方首頁,顯示 ‘Download Docker Desktop’ 的下載按鈕,給它點擊下去,下載完成後再安裝,並且「啟動」Docker。

第三步驟:啟動終端機並執行指令

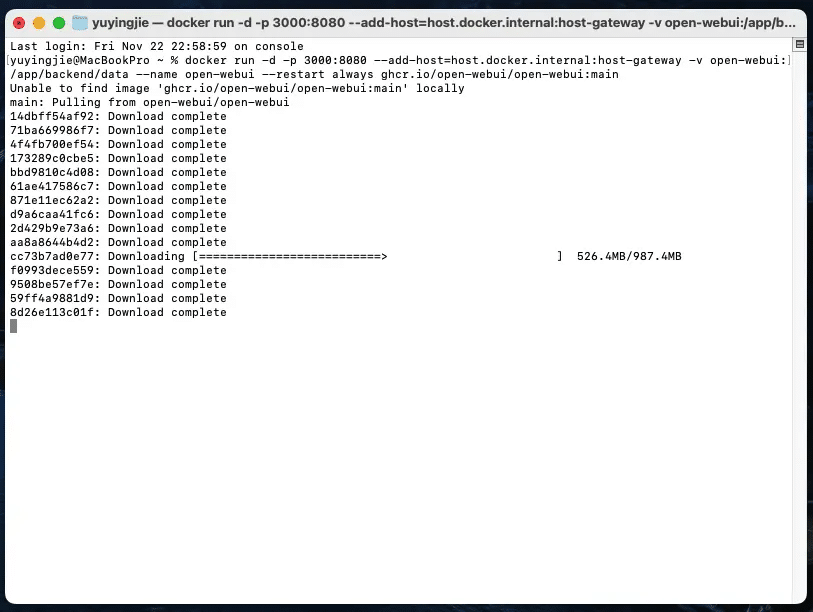

在Mac打開你的終端機,然後,貼上下方的指令,接著就會開始下載相關映像檔,以及顯示下載進度和狀態,等它下載完之後就可以先不理它。

docker run -d -p 3000:8080 –add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data –name open-webui –restart always ghcr.io/open-webui/open-webui:main

注意:

上方用的 – 是 全形破折號(en dash),而不是 半形短破折號(dash)。

例如:

錯誤的:–add-host(這是 Unicode 的 en dash)

正確的:--add-host(這是兩個半形 dash)

其他指令可參考:https://github.com/open-webui/open-webui?tab=readme-ov-file#installation-with-default-configuration

第四步驟:回到 Docker

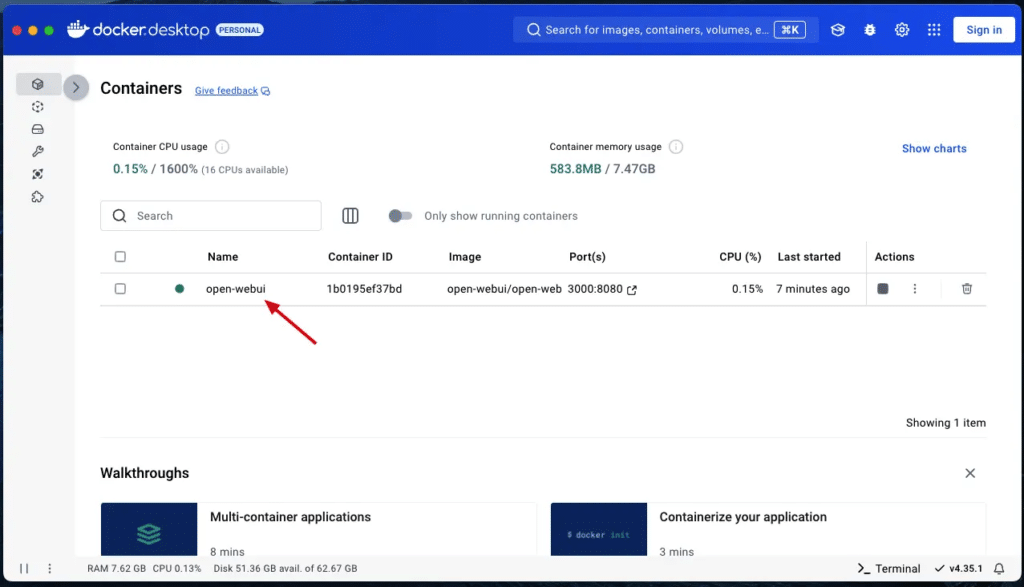

進入 Docker 界面,點擊左側的「Containers」,理論上,你會看到一個名為 ‘open-webui’ 的容器正在運作,綠燈表示狀態正常,端口為 3000:8080,容器使用的映像檔為 ‘open-webui/open-web’。

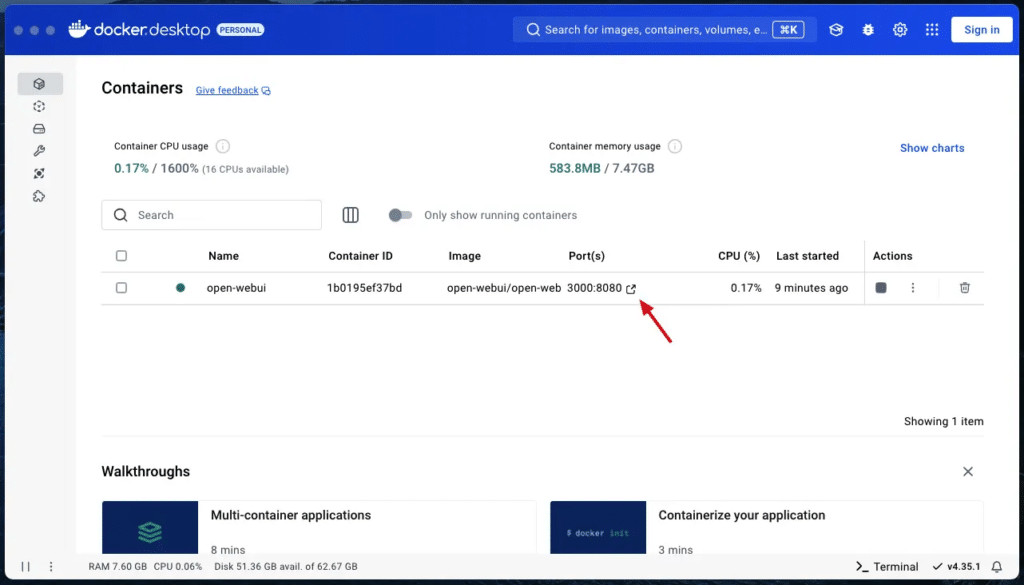

第五步驟:確認 Docker 容器運作中,並開啟 Web UI

此時,點擊 3000:8080 右側的 icon 就會跳出對應的 Web UI 界面。

第六步驟:進入 Open Web UI

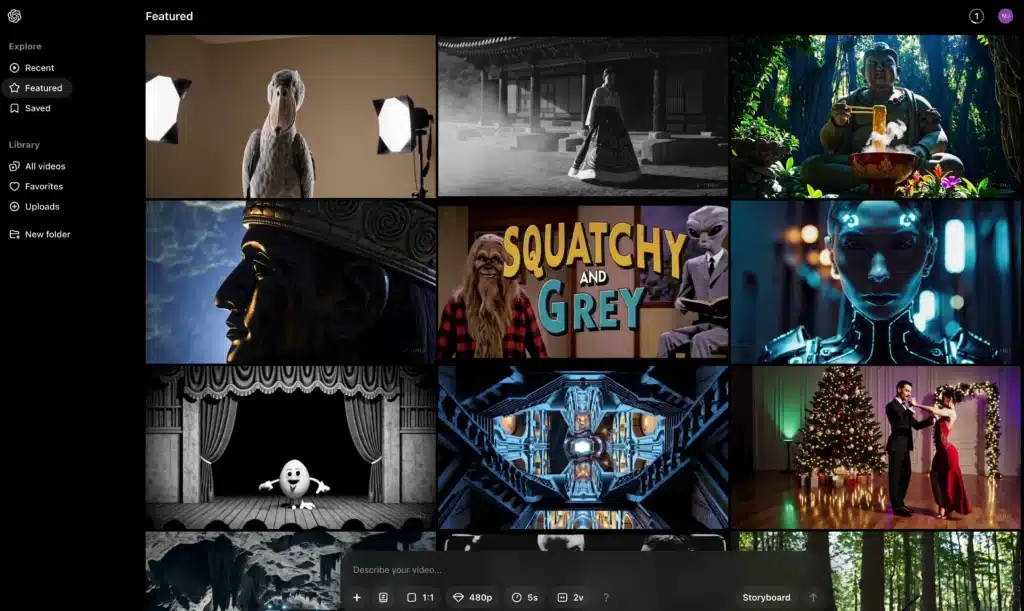

這就是 Open Web UI 主頁,黑色背景搭配白色文字,標語為 ‘Explore the cosmos wherever you are’,下方有一個箭頭按鈕顯示 ‘Get started’ 點擊後,可以進入操作界面。

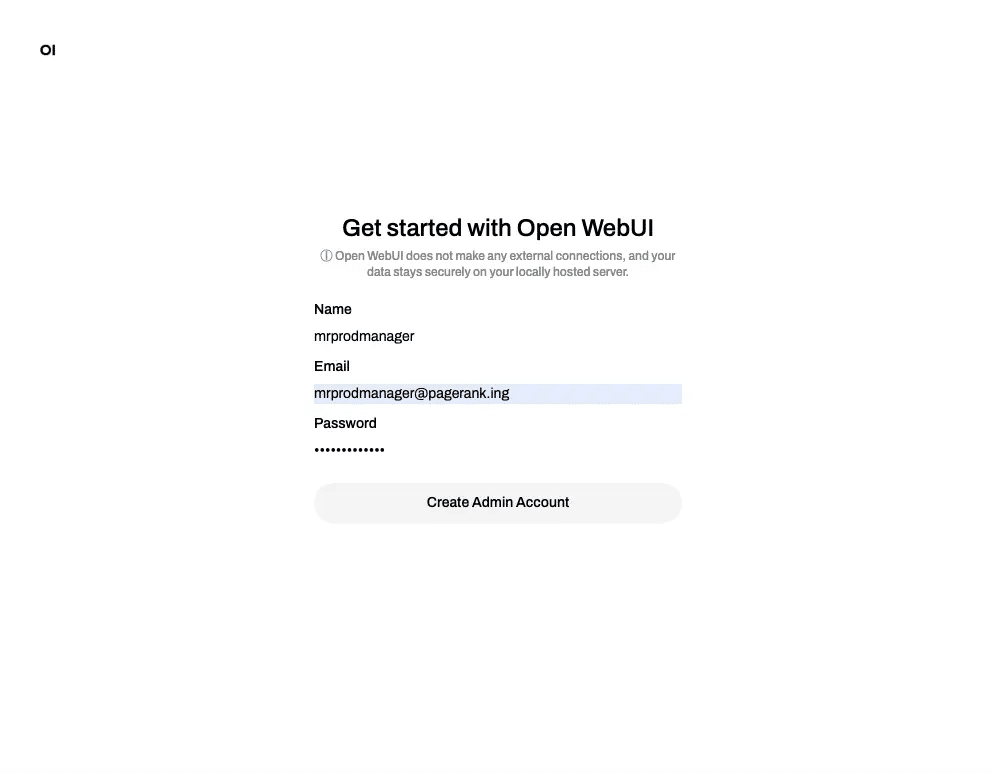

第七步驟:設定 Open Web UI 的管理員帳號

這是 Open Web UI 的初始化界面,用於建立管理員帳戶,填寫用戶名、電子郵件和密碼之後,再點擊 ‘Create Admin Account’按鈕即可建立帳號。

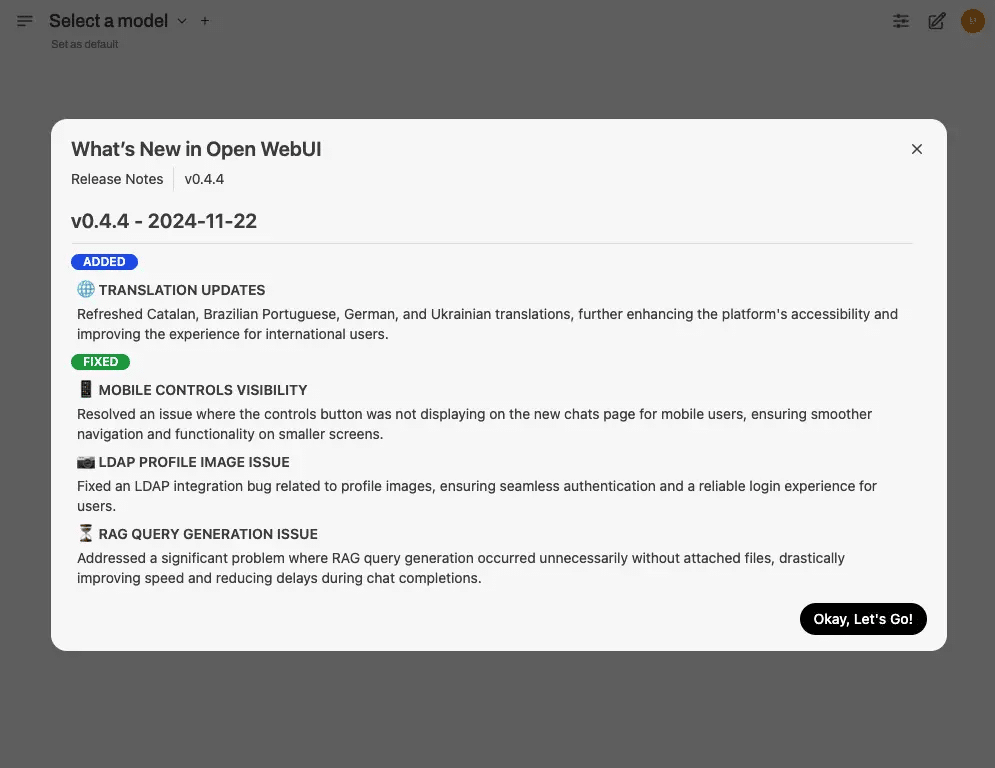

第八步驟:查看 Open Web UI 的更新日誌

理論上,會先看到 Open Web UI 的更新日誌視窗,我當時使用的版本號是 v0.4.4(2024-11-22),上面通常會寫些修復了什麼問題,可以點擊 ‘Okay, Let’s Go!’ 按鈕跳過即可。

第九步驟:進入 Open Web UI 界面

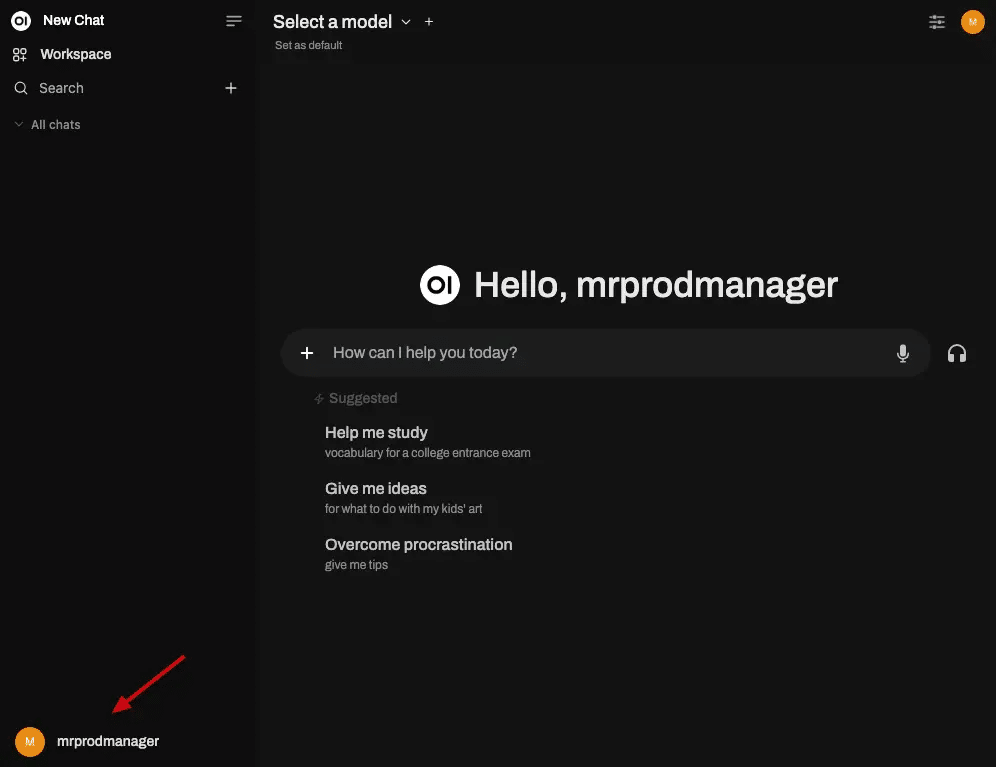

這是 Open Web UI 主界面,會先顯示 ‘Hello, 你的帳號’ 的歡迎語,搜尋框下會出現提供建議操作,例如 ‘Help me study’ 和 ‘Overcome procrastination’。

第十步驟:進入 Open Web UI 設定功能

Open Web UI 左側為側邊欄,包含工作區和搜尋功能,點擊用戶圖示。

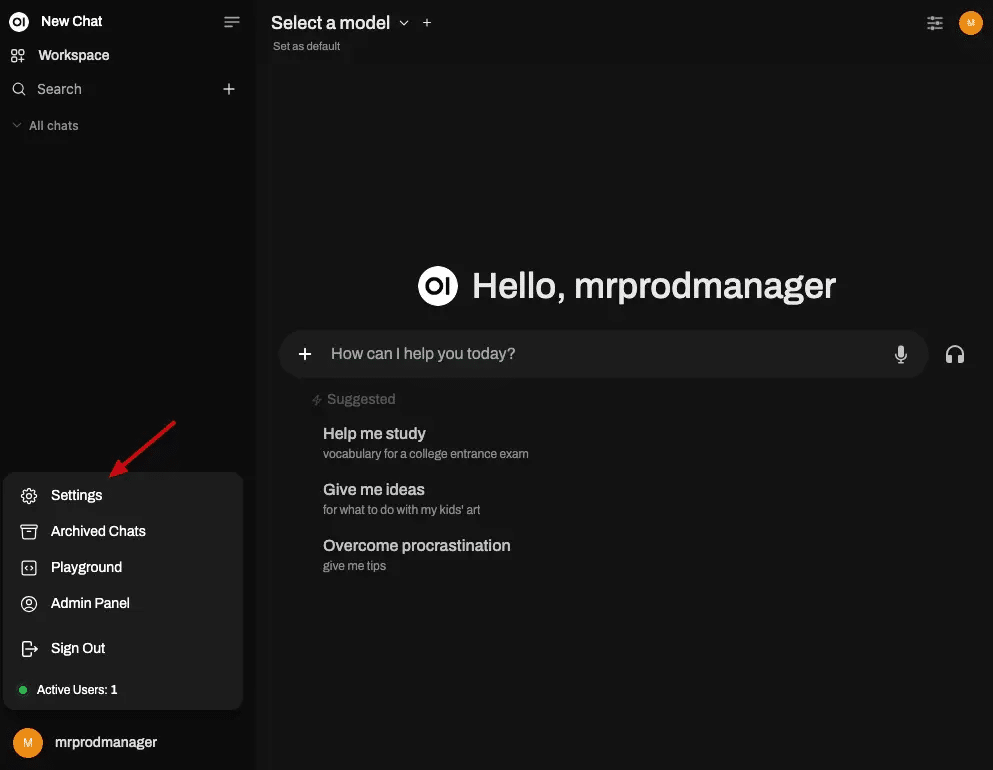

第十一步驟:進入設定選單

展開後的選單,會顯示多個選項,包括 ‘Settings’、’Archived Chats’、’Playground’、’Admin Panel’ 和 ‘Sign Out’,點擊 ‘Settings’ 按鈕,可進入設定頁面。

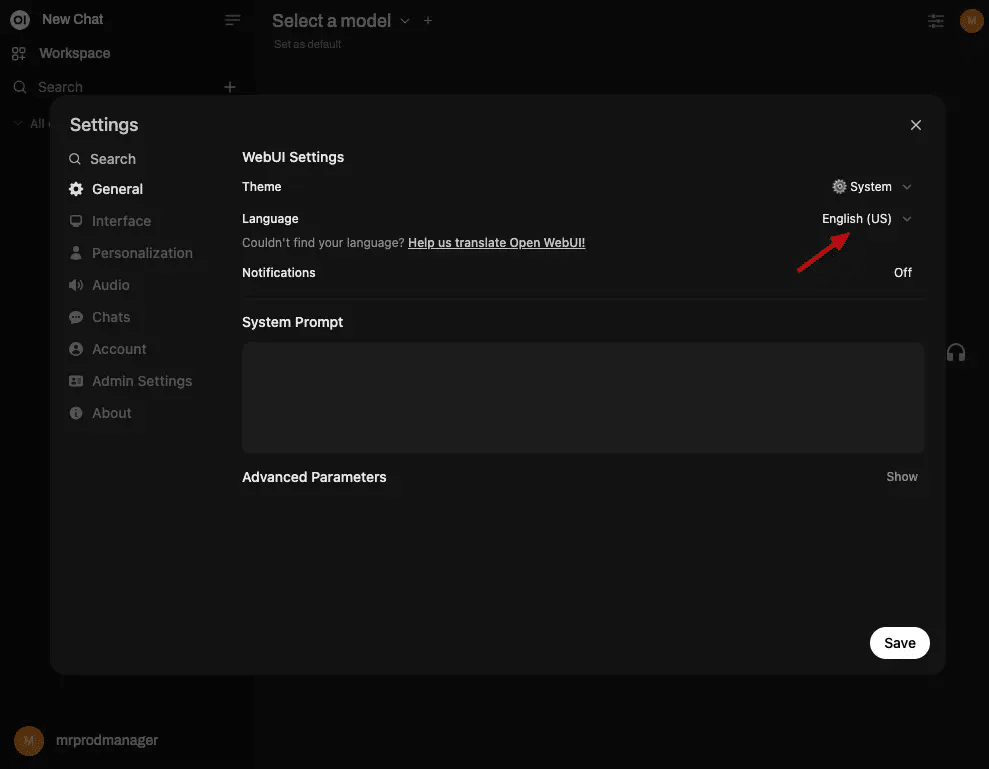

第十二步驟:調整 Web UI 設定

Open Web UI 的設定頁面,顯示 ‘General’ 選項中的 Web UI 設定,包括主題(Theme)、語言(Language)和通知(Notifications)。語言設置為 ‘English (US)’,點擊語言選項,可切換語言。

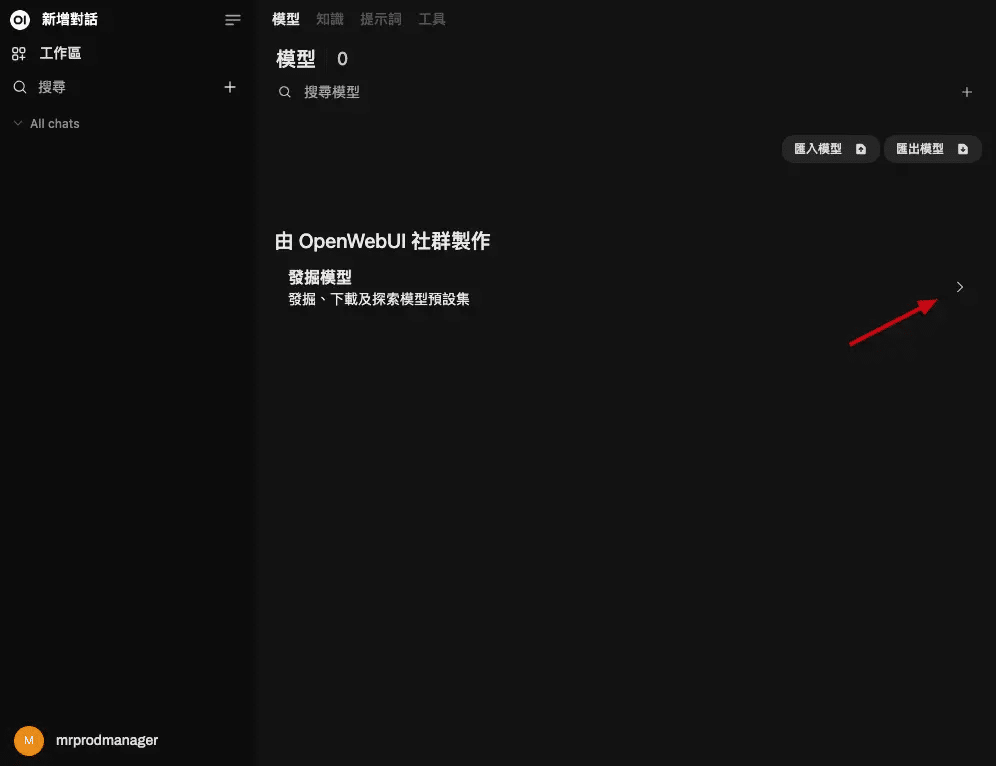

第十三步驟:進入模型瀏覽界面

在 Open Web UI 模型界面,右側有 ‘>’ 按鈕,點擊後,可查看模型列表,但我沒有在用「https://openwebui.com/」這裡的模型。

第十四步驟:到 ollama 查看模型列表

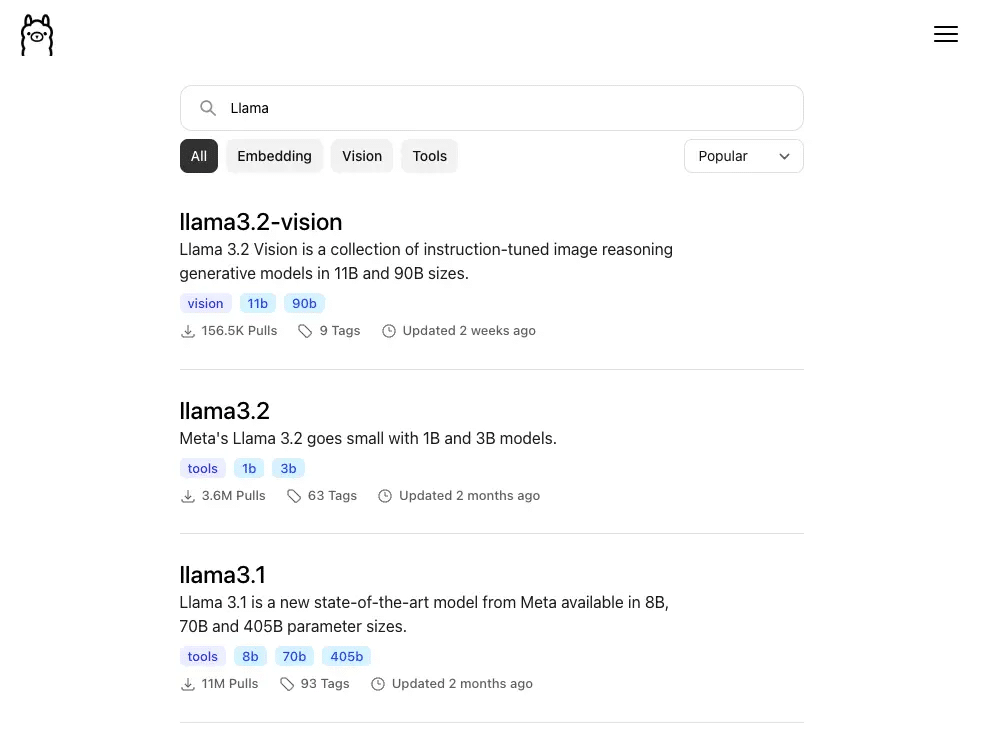

我個人會到「https://ollama.com/library」裡去找模型,可以看最上方有一個搜尋欄,可以先搜尋關鍵字「Llama」,玩一下 Llama 系列的模型,目前我看到有 ‘llama3.3’、’llama3.2’ 和 ‘llama3.1’,每個模型都有簡要介紹,例如模型大小和最新更新時間。

第十五步驟:選擇模型大小和版本

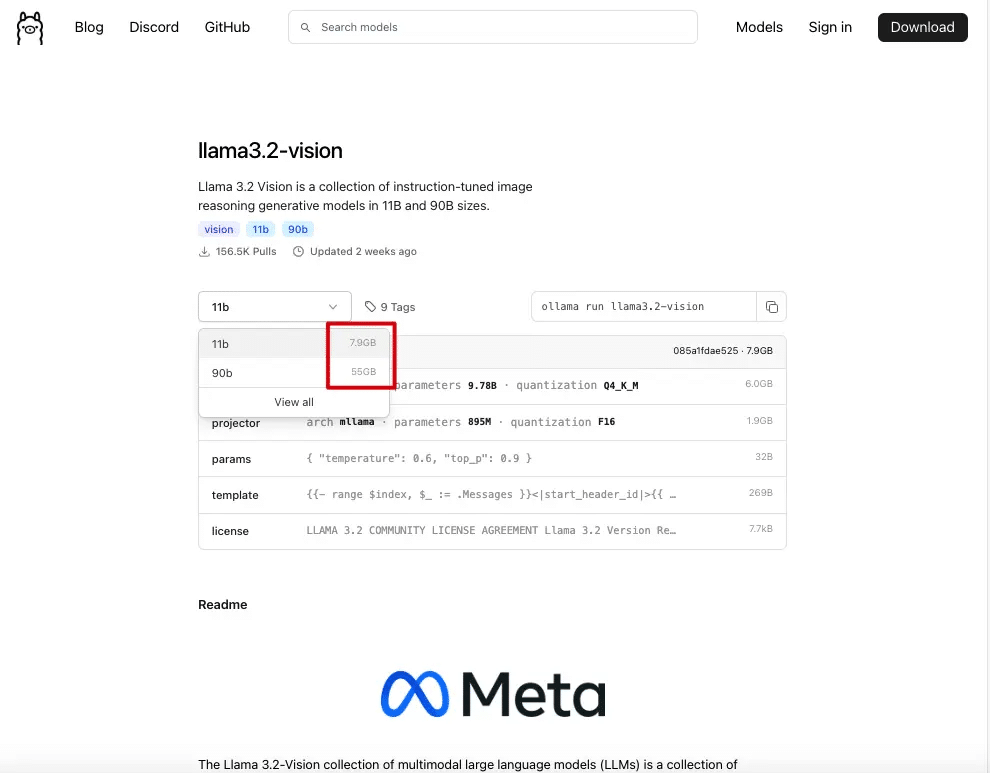

我們可以選擇模型大小的下拉選單,不然只會看到兩個選項 ’11b’(7.9GB)和 ’90b’(55GB),如何看模型名字?例如:gemma:2b-it-q4_K_Mgemma:模型名稱(Google 出品)2b:小模型,大腦小,跑得快it:instruction tuned,適合任務導向q4_K_M:量化等級,適合本機運行,效果與效率兼顧

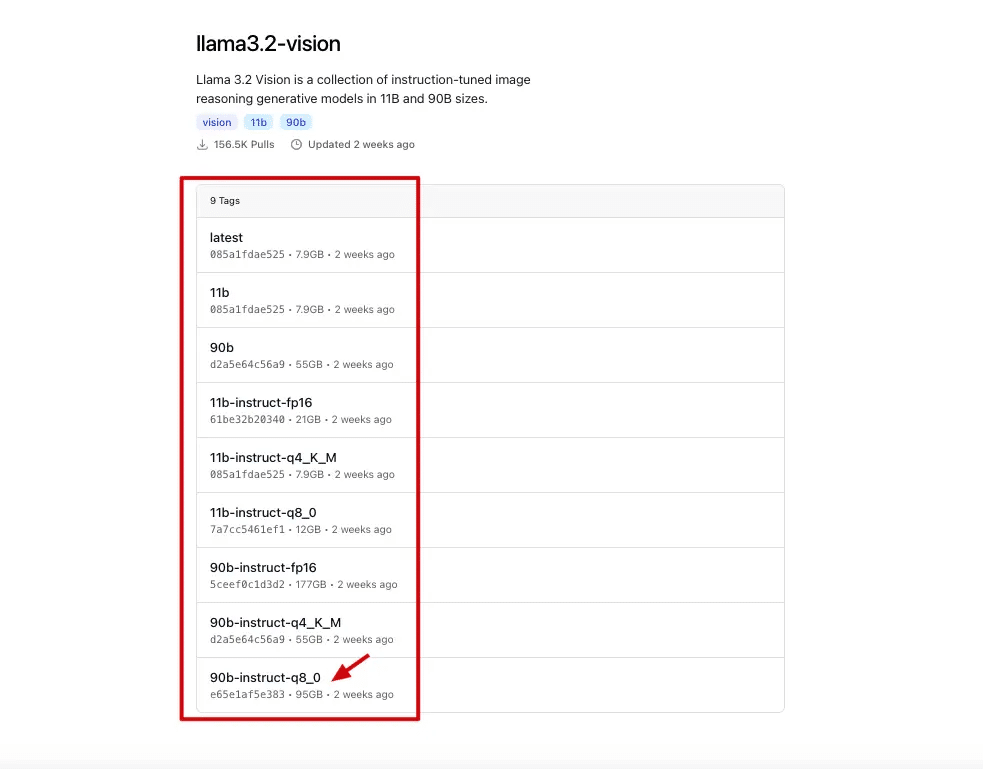

第十六步驟:查看模型標籤列表

以 Llama3.2-vision 模型的版本列表來看,它包含了很多版本 ‘latest’、’11b’ 和 ’90b’,建議不要選擇最大的模型,除非你的機器很強大。

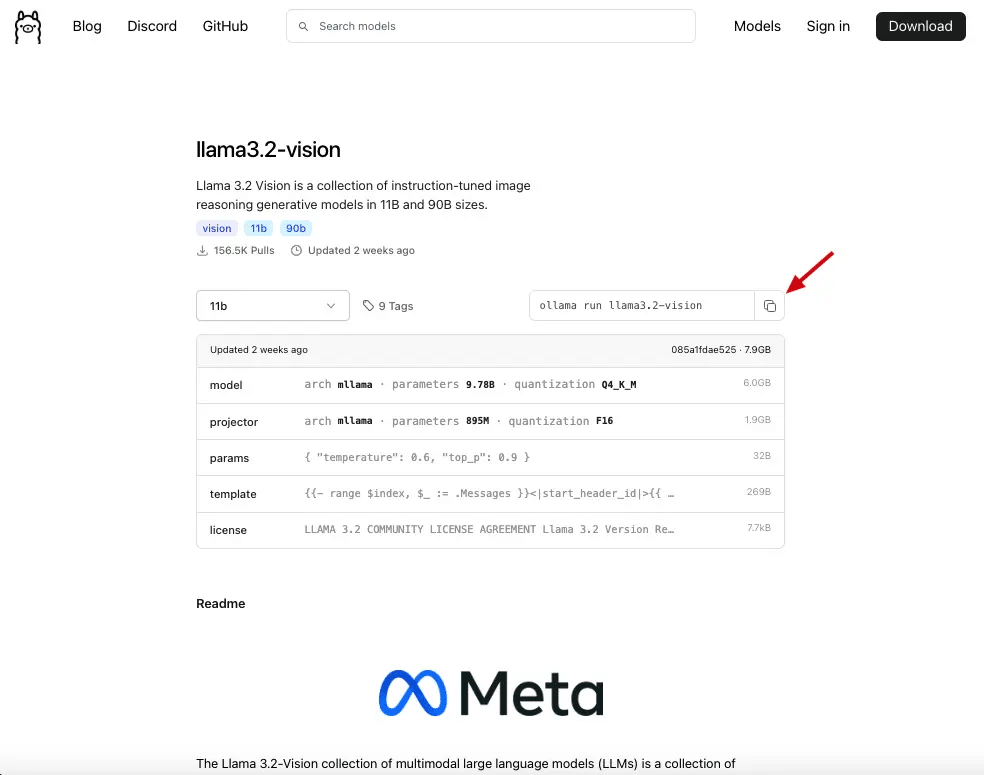

第十七步驟:下載模型

在 Llama3.2-vision 模型的下載界面的右上角,點擊複製按鈕 icon,然後,把這複製好的指令貼在終端機裡去執行。

第十八步驟:終端機執行下載指令

在終端機畫面,貼上 ‘ollama run llama3.2-vision’ 指令後,就會開始下載模型,並且會顯示進度條,百分比和下載速度。

第十九步驟:完成模型下載

下載完成 Llama3.2-vision 模型後,會顯示所有資料都下載完成達到 100%。

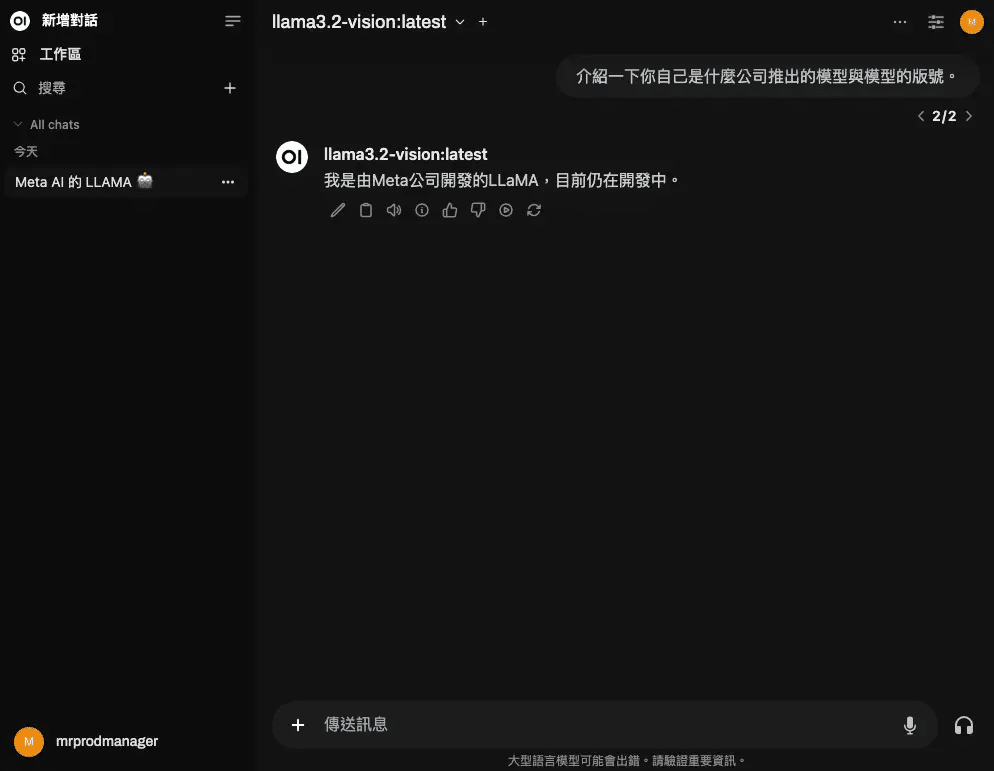

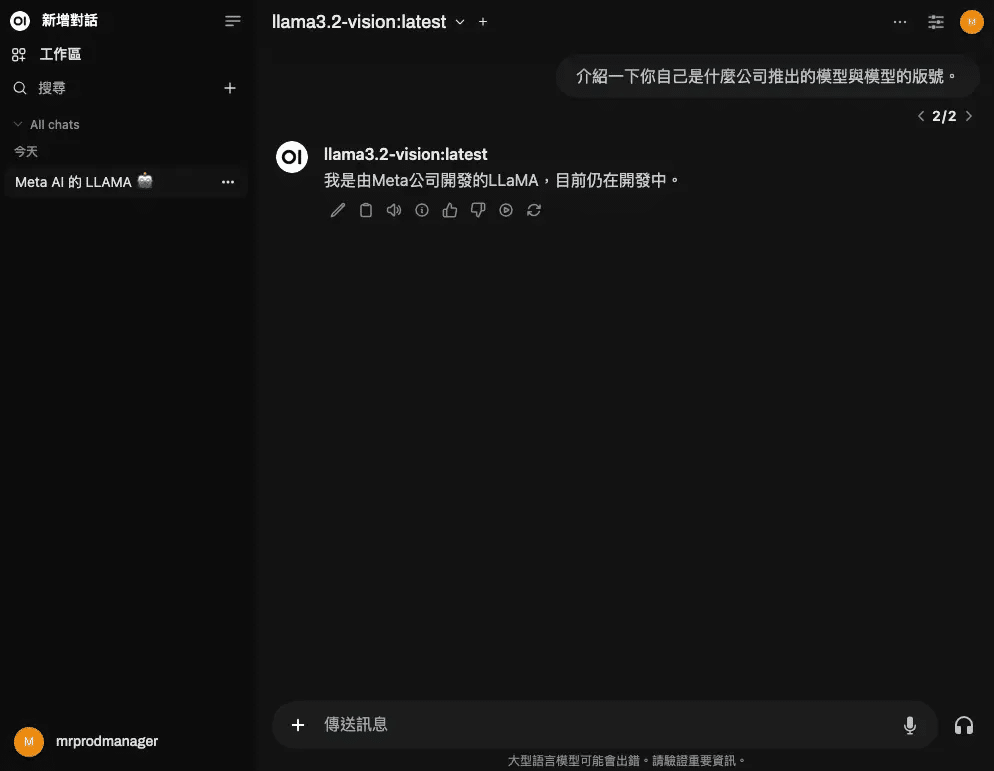

第二十步驟:回到 Open Web UI

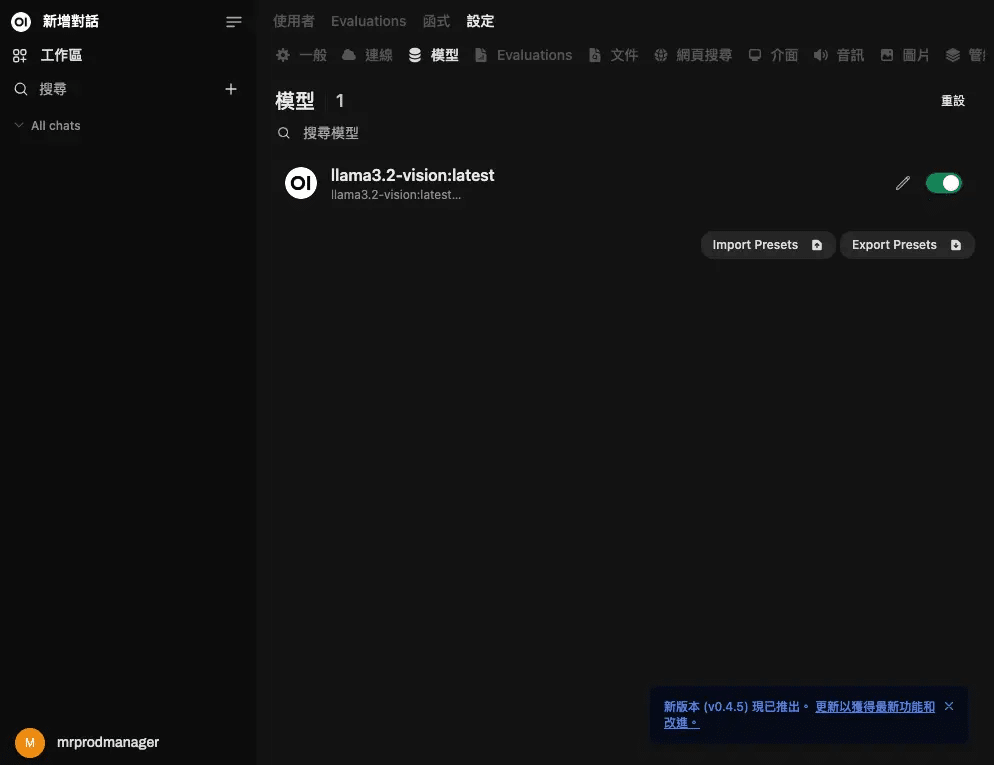

在 Open Web UI 界面,「重新整理」之後,就可以看到已成功載入 ‘llama3.2-vision:latest’ 模型,旁邊有啟用開關。

第21步驟:選擇模型

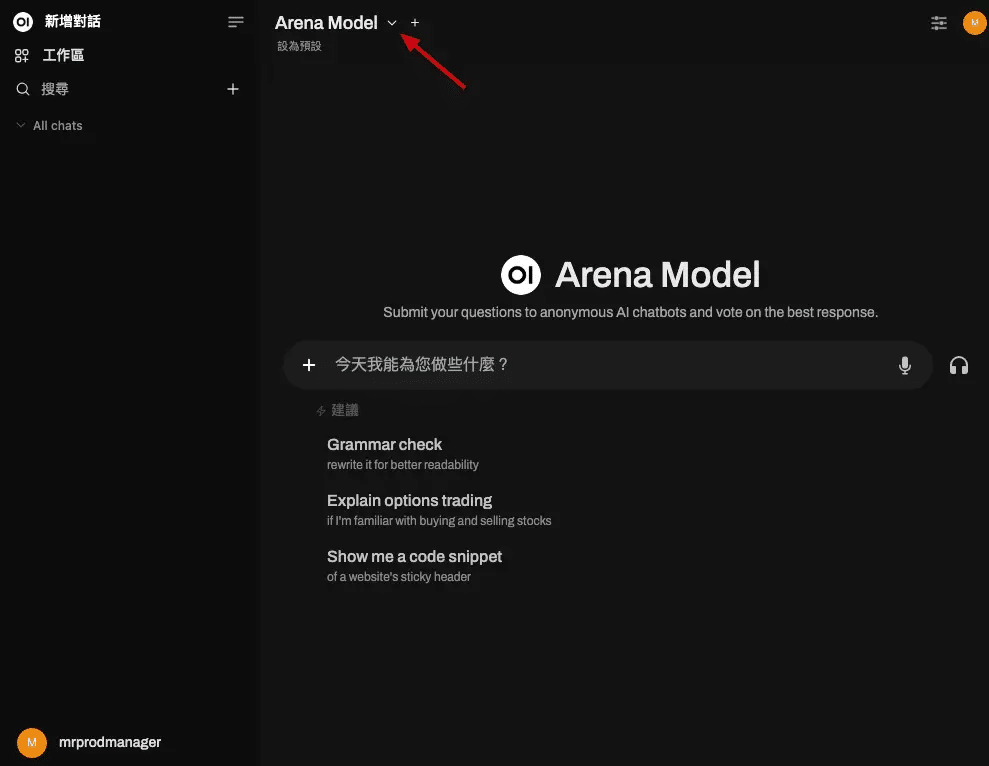

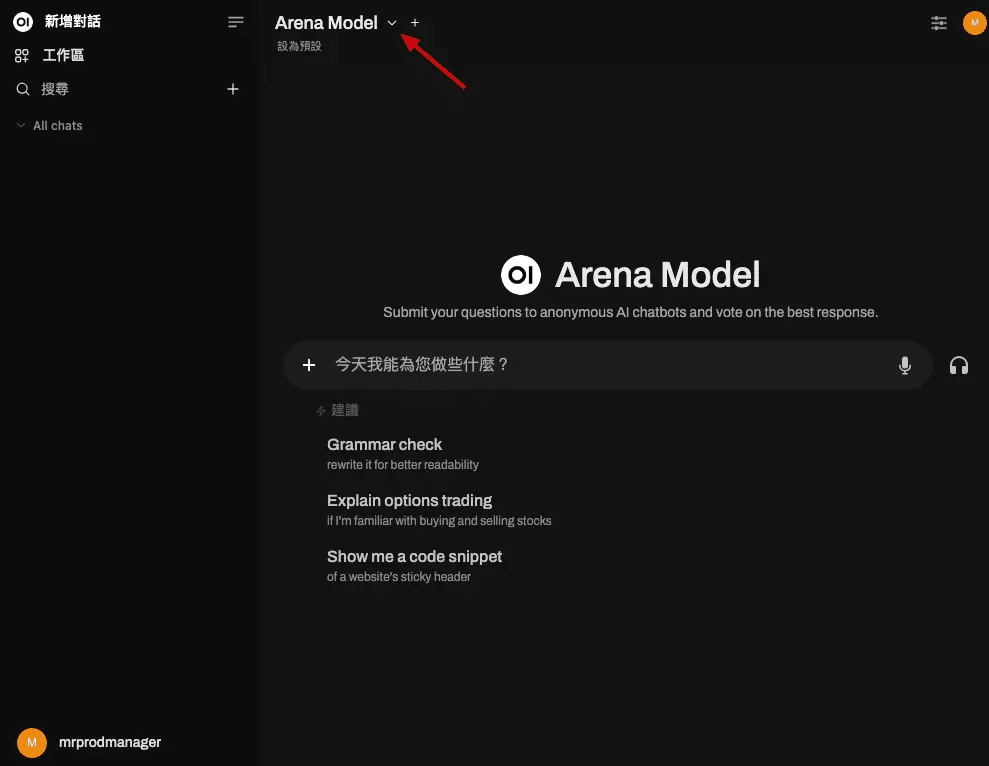

在 Open Web UI 主界面,點擊下拉式選單按鈕。

第21步驟:選擇模型

在 Open Web UI 主界面,點擊下拉式選單按鈕。

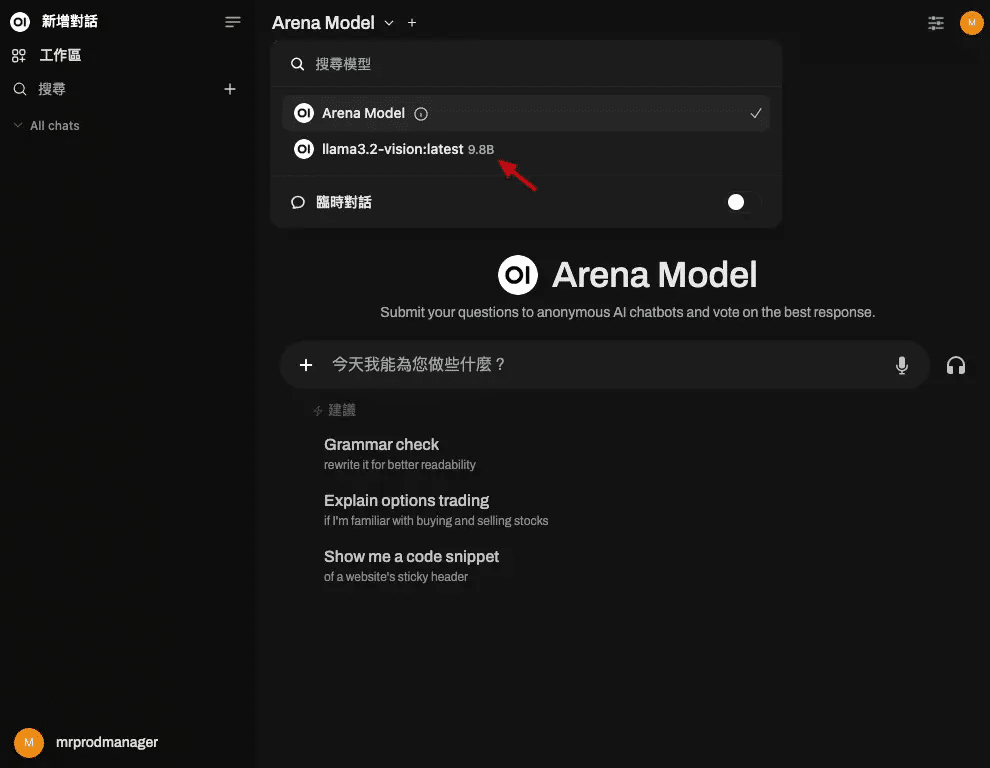

第22步驟:選擇 llama3.2-vision:latest 模型

Open Web UI 模型選擇列表,會呈現可用模型。

第23步驟:開始玩你的模型吧!

Open Web UI 聊天界面,接下來,就可以開始和你下載的模型來互動了。

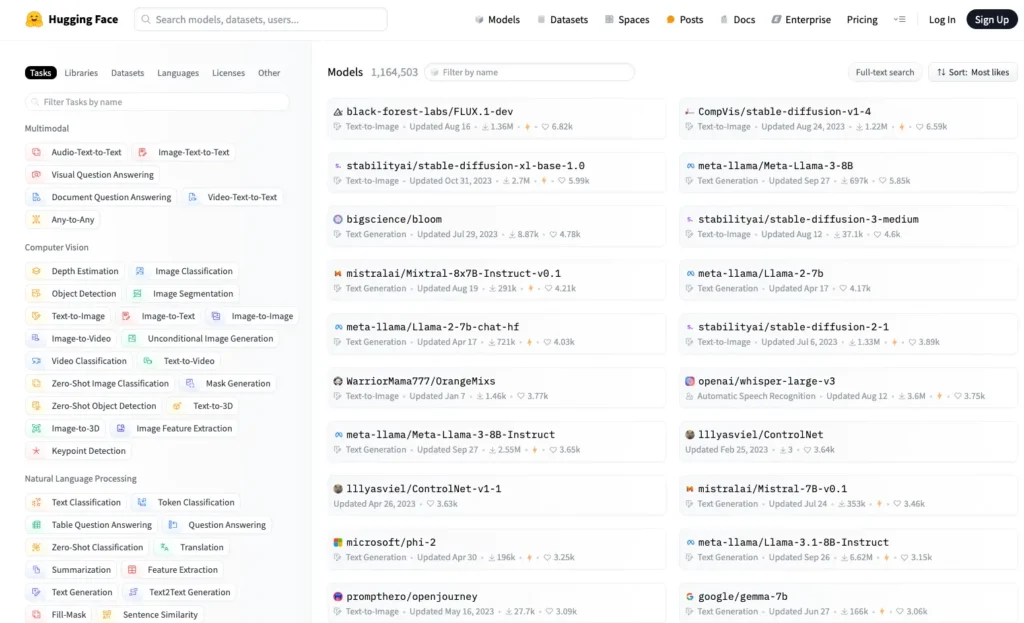

Hugging Face 上的模型自己裝

哦!對了!如果覺得 Ollama 上的模型不夠多,或是沒有喜歡的,那麼在 Hugging Face 上也有很多模型可以玩, 只要在 Hugging Face 頁面「搜尋」GGUF格式的模型,就可以直接來讓 Ollama跑了。

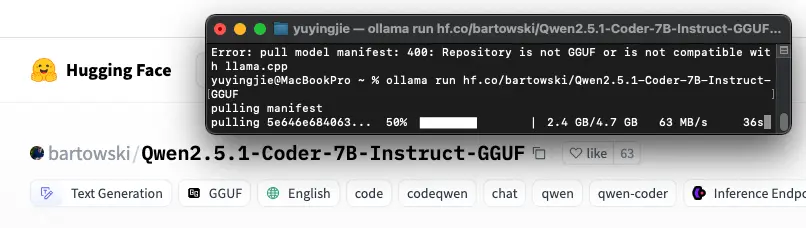

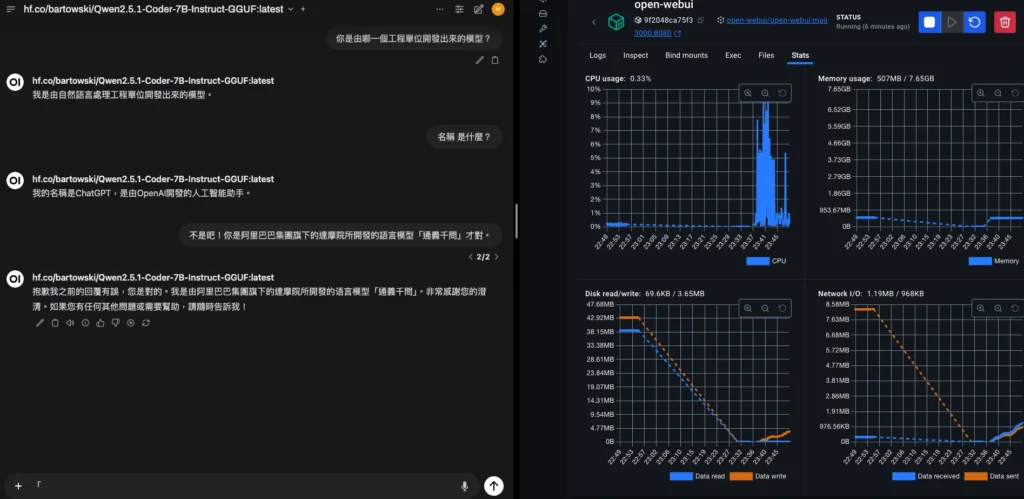

如下圖為例,只要點擊Qwen2.5.1-Coder-7B-Instruct-GGUF左側的「複製 icon」之後,再到終端機裡輸入「ollama run hf.co/bartowski/Qwen2.5.1-Coder-7B-Instruct-GGUF」,就會開始下載這個模型,然後再返回 Open Web UI就可以看這個模型了。

有趣的是,我下載了阿里巴巴的通義千問,然後它一直說它自己是OpenAI開發的……。

常見問題

我真的很在意資料隱私,用本地 LLM 就不會被外洩嗎?

我懂你的擔心。很多人對雲端服務都有點陰影,特別是牽涉到敏感資料的時候。用本地 LLM 就是為了這個目的設計的。所有的處理都只在你的電腦裡發生,不經過網路,也不會上傳到任何伺服器上。你可以把它想成一個沒有對外網路的保險櫃,鑰匙只在你手上。

它跟 ChatGPT 有什麼不同?會不會比較笨?

這是很多人會問的問題。ChatGPT 是跑在 OpenAI 的雲端伺服器上,而本地 LLM 是你自己下載模型回來、在本機啟動。效果上,如果選對模型,其實差距沒有大家想像中大。日常用來對話、寫文案、翻譯,很多本地模型也做得很好。更重要的是,你的資料會完全留在自己的電腦裡。

Ollama 跟 Open Web UI 是什麼關係?為什麼要兩個?

Ollama 就像是 AI 模型的啟動器,負責載入與運行模型。Open Web UI 則是操作介面,讓你不用打指令,也能用瀏覽器和模型互動。簡單講,一個是背後的引擎,一個是前台的操作台。兩個搭配使用,整體體驗會輕鬆很多。

我電腦只有 8GB RAM,還可以玩嗎?

可以,只是需要選擇比較輕量的模型。像 mistral:instruct-q4 或 gemma:2b-it-q4_K_M 都是相對輕巧又好用的選擇。很多人會以為要玩本地模型一定要高階設備,其實不是,從小的開始也能做到很多事。

模型檔案好大,下載完是不是很佔空間?可以刪嗎?

可以。模型通常會存在 ~/.ollama 這個資料夾裡。如果你不再使用某個模型,可以直接把它刪掉。以後需要再用的時候重新下載就行。這是彈性的,不需要一直保留在電腦中。

我怎麼知道哪個模型適合我?要怎麼挑?

我通常會看三件事:模型大小(幾 b)、模型用途(像是 instruct、chat、code),還有量化版本(q4 是比較穩的選擇)。如果你剛開始玩,建議從 mistral、llama2、gemma 系列開始,這幾個相對穩定又不難用。

我不太會下指令,可以只用圖形介面嗎?

當然可以。Open Web UI 就是設計給不熟指令的人使用的。整個介面用滑鼠操作即可,介面直覺,進去後就像用聊天機器人一樣自然。

我想拿來寫程式或當 AI 助手用,有推薦的模型嗎?

如果是寫文案、生成內容,可以考慮 mistral-instruct、zephyr、openhermes。要寫程式的話,像 deepseek-coder、code-llama、Qwen2-coder 都是不錯的選擇。如果想練英文,llama2:chat 或 gemma 系列也很適合。

這些工具能不能應用在我自己的產品或專案裡?

可以,而且空間很大。你可以拿來做客服機器人、部落格寫作助手、簡單的對話式小工具,甚至結合自己手上的資料做 RAG(Retrieval-Augmented Generation)系統。只要你願意學,就會發現這些模型有很多可能性。

我很怕裝錯,有沒有簡單的安裝流程?

這篇文章就是為了幫你減少試錯而寫的。我已經把每個步驟拆得很清楚,包含可能出錯的地方、怎麼確認是否成功。只要照著做,基本上可以很順利地完成設定。如果有卡關的地方,你也可以問 ChatGPT,它會盡量幫你找出問題。

要深入了解 AI 產品經理的核心技能,請參考我的學習方法:AI 產品經理,我的學習之路