Google 搜尋引擎是怎麼把網路上亂七八糟的資訊,瞬間變成你想要的答案?從1998年的簡單爬蟲到2025年的 AI 搜尋,Google 搜尋引擎每天處理幾十億查詢,靠的是 Googlebot 掃網頁、倒排索引整理資料,再加上 BERT、MUM 這些演算法搞定排名。本文要帶你拆解 Google 搜尋引擎的運作方式,從爬蟲、索引到呈現流程。

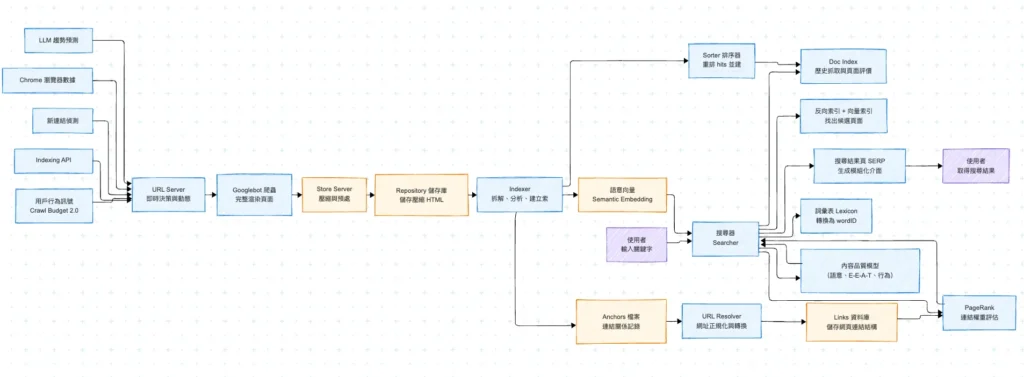

Google 搜尋引擎從爬蟲抓取到用戶取得搜尋結果的完整運作流程。從 URL Server 排程任務開始,Googlebot 執行抓取,經過 HTML 儲存、解析與建索引,接著由 Searcher 根據使用者查詢與語意向量比對候選頁面,再透過排序模型與 PageRank、E-E-A-T 信號共同決定最終搜尋結果呈現。整套流程強調即時性、語意理解與用戶價值。

在1998年時網頁內容沒有太多種類,但是Google 搜尋引擎的工作原理已經相當複雜,直至今日,面對更多樣化的資訊樣貌,Google 也是隨之對應,收集更多種類的資料給用戶們。

準備爬取:URL Server:網路探索的指揮中心

網頁爬取,也就是檢索,Google 採用分散式爬蟲系統,會有多個爬蟲同時運行。到了 2025 年,這個系統的規模和複雜度已經大幅進化,Google 的「爬蟲」早就不只是機械地抓原始碼,而是能完整渲染現代網頁的智慧代理,就像一個會開 Chrome 的人,把頁面打開、跑完 JavaScript,再抓資料。

補充一下:從 2024 年底開始,只要伺服器支援,Googlebot 預設會使用 HTTP/2 抓取網頁。這是一種比 HTTP/1.1 更有效率的傳輸協議,可以同時傳多個資源、減少等待。到了 2025 年,Google 在部分節點也開始測試 HTTP/3,這是基於 QUIC 協議的新一代 HTTP,特色是更穩、延遲更低,就算有封包遺失也能快速補上,不會卡住。

URL Server 是整個爬取系統的起點,管理著一份超大型的網址清單。這份清單分成兩種:一種是從沒爬過的,另一種是需要重新檢查的。不過現在已經不能把它想成一個靜態表格了,更像是一個全天候處理數十億個訊號的即時神經中樞。它會持續接收來自各地的訊號,例如網站主動提交的 Indexing API 資料、新發現的連結、甚至 LLM 預測的爆紅新頁面,動態決定誰該先被爬。

這些網址的優先順序是根據網頁的重要性、更新頻率,以及上次爬取的時間來定的。到了現在,這整套判斷已經變得極度智慧化,Google 內部稱這套機制為 Crawl Budget 2.0。它不再只是靠固定邏輯決定,而是會綜合「實際點擊量」、「用戶停留時間」、「內容互動性」等行為數據,交給機器學習模型做出排序。

這些行為數據從哪來?就是 Chrome。當你用 Chrome 開某個網站,Google 能看到你有沒有點、看多久、有沒有滑動、有沒有馬上關掉。這些都是預測哪個頁面「還值不值得再抓一次」的重要依據。也因為 Chrome 的市佔率高、資料即時,Google 在這部分擁有業界幾乎無法取代的優勢。

熱門頁面會自動加班,讓 Googlebot 更頻繁地來光顧;反之,如果沒人看、跳出率高,系統就會自動降頻,爬蟲不浪費力氣。對搜尋引擎來說,這樣既節省資源,也能把用戶看到的結果維持在最即時、最有價值的狀態。

站在產品經理的角度來看,這邏輯太合理。Crawl Budget 不是什麼平均分配資源的社會福利制度,它本質上就是一種投資分配機制。該給誰多一點機會,當然是看誰「真的對使用者有價值」。這不只是效率問題,更是產品價值最大化的基本盤。

這一連串決策背後的依據來自 Doc Index 資料庫。這個資料庫記錄了每個網頁的 docID、對應的 URL、歷史抓取紀錄、內容摘要等。URL Server 再根據 PageRank 或其他信號評估哪個網頁比較重要。舉例來說,首頁、媒體網站、經常更新的部落格,基本上會被優先處理。

PageRank 是 Google 最早用來評估網頁重要性的演算法,簡單來說就是「很多頁面都連到你,那你應該蠻重要」。但在 2025 年的實務上,它已經不再是唯一依據,而是與各種機器學習模型協作,進一步預測網頁的易變性、品質,甚至重新抓取的投資報酬率。像是系統會知道某部落格每週二早上會更新,那就定時來;另一個論壇可能熱門話題十幾分鐘內就翻篇,那就插隊來爬。

更進一步,Google 的 LLM 會分析全網趨勢流,預測下一波可能爆紅的新主題、新 URL,直接插隊進高優先級佇列。這整個動態架構,建立在幾年前推出的 Caffeine 即時索引系統上,讓資訊更新速度維持在全網最快。

爬蟲抓完頁面後,還會解析裡面的連結,再回傳給 URL Server,這樣清單不斷更新。這個循環流程在 2025 年變得更細緻:現在的 Googlebot 不再只是單純讀一份 HTML 原始碼,而是會真的「打開網頁、跑完整個頁面」,包含裡面用 JavaScript 動態產生的內容,像極了真人用瀏覽器的行為。這是為了確保它抓到的畫面,就是使用者實際會看到的樣子,而不是一堆還沒渲染的程式碼。

在抓資料的同時,Googlebot 也會順手把網頁中的額外資訊一起處理,例如,頁面有沒有加上清楚的資訊、是不是有影片、甚至是不是有提供外部服務的介面,這些都會納入理解範圍,讓搜尋結果變得更立體。

而為了省資源、提升效率,Googlebot 不會每次都傻傻地重抓。系統會先預估這頁面有沒有可能改過,如果沒什麼變化,就直接發出一個特殊的代碼,通知伺服器「我不抓了,這頁跟上次一樣」。這種方式大約可以省掉三成以上的頻寬,對 Google 這種級別的爬蟲系統來說,是非常可觀的節省。

如果網站本身有支援一種叫做「預抓提示」的功能,Googlebot 甚至能在伺服器還沒完全準備好之前,就搶先把關鍵資源先下載好,讓整個網頁載入再快一拍。

更重要的是,這些抓回來的資料,已經不是等到半夜才慢慢排隊上傳或更新。現在整個流程是即時的、串流的,爬蟲抓回的東西立刻進入索引系統,幾乎可以做到即時更新,反映在搜尋結果上。

爬蟲開始爬取:Crawler,從網址出發的資料搬運工

爬蟲從 URL Server 取得需要前往的網址,例如,搜尋引擎的爬蟲會到達「https://pagerank.ing/」這個網址。但它不是一到就埋頭猛衝,我們產品經理的第一思維是「效率」,所以爬蟲會先禮貌性地帶上上次訪問的快取資訊(像 ETag),問網站說:「嗨,這頁有更新嗎?」如果網站回應「沒變」(技術上是 304 Not Modified),那這次的爬取任務就直接搞定,省下的資源可以拿去爬更多新東西。

如果頁面有更新,就進入下一步:下載網頁內容。爬蟲將從該網址下載 HTML 內容。這裡的「下載」在 2025 年也充滿了學問。首先,我們預設用 HTTP/2 進行連線(白話解釋:像把單線道升級成多線道,一次可以同時溝通好幾件事),在越來越多的節點上,甚至採用基於 QUIC 協議的 HTTP/3(白話解釋:一套更聰明的貨運系統,就算中途丟了一箱貨,也不會讓整批貨運卡住)。這一切都是為了用更快的速度,榨出更多的下載效能。

再來,說「下載 HTML 內容」其實只對了一半。在現代網頁充滿 JavaScript 的情況下,只抓 HTML 等於只拿到房子的骨架,血肉全都會漏掉,這對用戶來說是災難。所以,標準作業流程是把頁面丟進內部的「網頁渲染服務 (WRS)」,它就像一個超高速的 Chrome 瀏覽器,把所有 JS 都跑一遍,確保 Google 看到、抓到的,跟用戶螢幕上顯示的一模一樣。

接收與儲存:Store Server,為索引鋪路的收發中心

爬蟲收集到的 HTML 內容,會被傳送到 Store Server 裡,而每一個 HTML 網頁內容,都會給一個唯一的 docID(文件編號),用來識別和索引網頁,並且,將 HTML 內容「壓縮」並「儲存」到 Repository 儲存庫中。

而這些事情,都是為了索引而準備。

在 2025 年,這一步不只是單純存檔而已,而是一個結合預判、壓縮、分類與後處理的整合作業。從爬蟲抓回內容的第一刻開始,系統就會立即進行格式清洗、雜訊去除,並試著判斷這頁是不是重複內容(像是換湯不換藥的轉載文、列表頁、或是參數頁),如果重複性太高,後面乾脆就不進索引,節省處理資源。

而儲存這步驟的「壓縮」也比過去進化不少,不再只是 gzip 或 Brotli 這種單一壓縮格式,而是根據不同內容類型,選擇更適合的儲存方式。舉例來說,純文字頁面、圖像導向頁面、影片串流頁,現在會走不同的儲存策略,分別最佳化存取頻率、儲存空間與解壓縮時間,讓系統資源的使用率達到最省、但又最快的平衡點。

另外,從 Store Server 到 Repository 的這段傳輸流程,也升級成具備節流與預測機制的串流通道。簡單說,就是系統會根據「這篇內容可能的搜尋價值」來分配處理優先順序。新聞快訊、剛爆紅的 Reddit 貼文、即將成為趨勢的產品比較頁,會被插隊先處理;而冷門內容,可能就會進入後補佇列,靜靜等著資源輪到它。

身為產品經理,看這段流程時會很清楚一件事:系統不是為了「抓資料而抓」,而是從一開始就評估「這份資料的可用性、可搜尋性、能不能為用戶創造價值」。只有真的會進入搜尋結果、可能被點擊、可能解決使用者問題的內容,才值得後面花大成本處理。整個 Store Server 系統就是為這樣的資源分配策略鋪好管線,確保資料留下來是有意義的,而不是堆硬碟、吃電又沒產出。

這就是搜尋引擎的資料收發中心,不只是把 HTML 收下來,而是開始進入「哪些資料要留下、哪種方式最適合保存、值不值得進一步理解」的產品思考階段。

建立索引:Indexer,從內容拆解到搜尋入口的第一道關卡

Indexer 會去讀取 Repository 儲存庫裡的壓縮檔案,它會將檔案解壓縮之後,開始分析這些 HTML 內容。但在 2025 年,我們對「分析」的定義已經徹底改變了。過去的分析,是把網頁看成一堆「關鍵字」的集合;現在的分析,是透過大型語言模型(LLMs)把它當作一篇需要「理解」的文章。

分析的方式,就是將網頁內容拆分為文字、標籤(tags)和其他元素。在這個過程中,Indexer 會識別出網頁中的「詞彙」,並且記錄這些「詞彙」它們在 HTML 頁面中的第幾行、第幾個、字體大小以及大小寫等資訊。這個拆分過程依然存在,但 2025 年的「hit」含金量遠不止於此。

這些的每一筆「詞彙」記錄,被稱為「hits」。除了記錄位置、字體大小這些傳統信號,Indexer 更核心的工作,是為每個詞、每段話,甚至每張圖片和影片片段,都產生一組「語意向量」(semantic vector)。白話講,就是為內容產生一組獨一無二的「意義座標」,這組座標能表達它真正的意思,而不是字面上的符號。

接著,Indexer 會將這些 hits 分配到多個「barrels」(資料桶)當中,並且,每個 barrel 內的 hits 是按照 docID(文件編號)來排序的。然後,Indexer 開始建立正向索引(forward index)和反向索引(inverted index)的初步建立。這個流程依然是系統的骨幹,只不過,現在的索引,除了索引「詞彙」,更索引了剛剛提到的「意義座標」。

正向索引意思,是指按照「網頁」的順序,對於每個網頁都會記錄出現了哪些詞彙,以及這些詞彙的詳細資訊(位置、字體大小、大小寫),目的是要能夠快速反饋出特定網頁資料的查詢,例如,這個網頁上包含了什麼詞彙,很適合「全文檢索」的使用場景,但這不適合「哪些網頁包含了這些詞彙」,這種索引方式得要查詢所有網頁才能找到。

因此,就有了反向索引這件事了。它是按照「詞彙」的結構所組成,簡單講,就是記錄每個詞彙在哪個網頁上出現過、以及出現的次數和位置。如此一來,就可以快速回應特定詞彙的查詢在哪些網頁出現過,但這個結構就不適合特定文件的查詢。而現在,因為有了「意義座標」,我們的反向索引就能做到「概念搜尋」。用戶問「台北信義區那棟有大球的樓」,我們能透過意義座標的相近度,直接匹配到「台北 101」的相關文件,這就是最大的用戶價值所在。

而這就是 Indexer 負責建立的正向索引和反向索引的初步建立。

| 結構名稱 | 功能說明 | 資料單位 | 用途 | 優點 | 限制 |

|---|---|---|---|---|---|

| 正向索引 | 按照每個網頁記錄該網頁內所有詞彙及其細節 | docID | 查某個網頁出現哪些詞 | 快速列出單頁內容 | 無法查詢「哪些頁含有某詞」 |

| 反向索引 | 按照詞彙記錄該詞出現在哪些網頁,以及出現次數與位置 | wordID(搭配 docID) | 查某個詞在哪些頁出現 | 快速查詢關鍵字相關網頁 | 查整頁內容效率不高 |

| Lexicon 詞彙表 | 統一管理所有詞彙及其 wordID 對應 | wordID | 為搜尋系統提供一致詞彙編號與語意處理依據 | 標準化詞彙、支援多語系 | 詞彙量大時記憶體管理複雜 |

另外,Indexer 還要負責建立一個稱為 Lexicon(詞彙表)的結構,這個表記錄了網頁中出現過的所有詞彙以及對應的 wordID(詞彙編號)。這個 Lexicon 在今天也已經進化成我們的「知識圖譜 (Knowledge Graph)」。它把每個詞彙都被賦予一個唯一的編號 wordID,這個編號用在整個搜尋引擎系統中識別和引用該詞彙。但更重要的是,知識圖譜還記錄了詞彙之間的「關係」,例如它知道「馬斯克」是「特斯拉」的執行長。而有了詞彙表,就能夠支援反向索引的建立,因為,反向索引就是使用詞彙結構來快速找到包含特定詞彙的所有 HTML 內容,而 wordID(詞彙編號)和詞彙表確保了這個過程的準確性,知識圖譜則讓搜尋結果能直接提供答案。

Indexer 要做的事情有點多,它還負責分析 HTML 內容中的「連結」,它會把每個連結的文字、來源網頁和目標網頁都記錄下來,就像在筆記本上畫了一張網頁間的關係圖,而這被記錄下來的東西,就稱為「Anchors 檔案」。這個檔案在 2025 年也變得更聰明了,Indexer 不只記錄連結文字,還會用語言模型去分析連結前後文的語氣和主題,更精準地判斷這個連結的「推薦強度」和「主題相關性」。一個在專業論文裡推薦的連結,跟一個在論壇閒聊中提到的連結,它們的權重當然完全不同。

總結來說,2025 年的 Indexer,早就不再是個只會埋頭整理書本、抄寫詞彙卡片的圖書館員。它更像一個能讀懂每一本書、理解作者意圖、還能畫出人物關係圖的超級研究員。它的終極目標,是為用戶下一次的查詢,預先建立一個能真正「理解」問題,而不只是「匹配」文字的知識。

Indexer 工作流程:一條龍拆解

- 接收檔案

從 Store Server 收到壓縮後的 HTML 資料。 - 解壓縮與預處理

解開壓縮,清洗雜訊,排除重複內容或無效頁面(像是參數頁、內容雷同頁)。 - 拆解 HTML 結構

將頁面拆成詞彙、HTML 標籤、屬性、結構,建立「hits」清單,記錄每個詞出現的位置、大小寫、字型資訊等。 - 分桶(barrel)分類

依照每筆資料的 docID,將 hits 分配到不同資料桶,方便平行處理與索引建構。 - 建立正向索引

每個 docID 對應該頁面所有詞彙的完整清單,方便後續全文檢索或展示用。 - 建立反向索引

依照詞彙倒過來查:每個詞出現在哪些 docID 裡、出現次數與位置,支援關鍵字搜尋。 - 建立 Lexicon(詞彙表)

為所有詞彙賦予唯一 wordID,支援詞彙標準化、多語比對與反向索引查找。 - 分析結構化資料

辨識網頁中的結構化標記(例如 Schema.org),提取商品、FAQ、評論等資訊,讓搜尋結果更有內容。 - 分析語意向量(2025 強化項目)

使用大型語言模型處理網頁語意,建立語意索引(semantic embedding),支援 AI 概覽與語意搜尋。 - 處理 Anchors(超連結關係圖)

記錄每個超連結的來源頁、目標頁、連結文字,作為 PageRank 計算與語意脈絡的一部分。

排序器接手:Sorter,把索引資料洗成搜尋能用的樣子

Sorter 接手由 Indexer 建立的 Barrels。這個時候,Sorter 接收到的 barrels 中的 hits 是按照 docID 排序的,但 Sorter 會將它們重新排序,按照 wordID 的順序排列,以生成反向索引(inverted index)。

wordID 的排序,是將所有在網頁中出現過的詞彙,按照它們的 wordID(詞彙編號)由小到大進行排序。wordID 是 Google 為了方便處理和儲存詞彙資訊而給每個詞彙分配的一個獨一無二的編號。這麼做是建立完整的反向索引(inverted index),例如下面兩張表格。

到了 2025 年,這段流程看似只是個「資料重新排一下順序」的任務,實際上早已成為搜尋速度與成本控制的核心關鍵。

第一個提升:

是在排序策略本身。現在的 Sorter 不只是照 wordID 從小排到大,而是會根據詞彙的「熱門程度」與「出現密度」進行動態調整。舉例來說,像「的」、「and」、「the」這類超常見的詞,在排序時會放在獨立索引區塊,用壓縮方式處理,避免拖累整體搜尋效率。這種針對高頻詞的優化做法,有點像是電商網站會把出貨量超高的商品另外建快取區一樣,有流量就要有對策。

第二個強化點:

是排序過程中引入了並行運算架構。以前這種重排序是單線跑完,現在會切成多段、分配到數百個資料處理節點平行完成,再即時整合。這套架構在過去叫 MapReduce,但在 2025 年,Google 採用的是更進階的內部版本(如 Flume、Dataflow),能即時處理 TB 等級的資料洗牌,不只是快,而是「幾乎不會卡」。

補充一下,以前 Google 在處理大量資料時,用的是一套叫做 MapReduce 的方法。這種方式有點像工廠組裝線:先把資料拆小塊,分給很多機器同時處理,最後再把結果拼起來。但它有個缺點,就是要等所有資料都處理完,結果才會出來,速度比較慢。

到了 2025 年,Google 不再只靠這種舊方法,而是改用內部更先進的系統,像 Flume 和 Dataflow。

這些新系統的差別是什麼?簡單講:

- 不用等資料都到齊才能開始處理

- 能邊收到資料邊處理,像是直播一樣即時

- 資源分配更聰明,遇到熱門內容時能自動加速處理

就像過去是用一台 CD 燒錄機排隊燒資料,現在是換成 Netflix 直接邊看邊載,不只快,而且不中斷。

對用戶來說,最大的好處就是:搜尋結果更新更即時了,當某篇新內容剛被爬蟲抓到,馬上就能出現在搜尋結果上,不用再等幾個小時排隊進系統。

而第三個看不見但很關鍵的差異:

是 Sorter 現在在排序同時,還會順手進行「詞彙上下文關聯建模」。簡單講,就是在排資料的同時,也會一併記下「哪些詞彙經常一起出現」、「詞與詞的語意距離」、「同一個字詞在不同網頁的用途有沒有偏移」。這些語意共現資料,會儲存在語意圖譜中,供 AI 模型後續判斷語意與意圖。

這些看似「背景重整資料」的動作,最後對用戶的價值是什麼?就是當你輸入一個搜尋關鍵字時,系統能秒出結果,而且不只是有對應,而是找出那些真的「懂你要找什麼」的頁面。這就是我們在產品上最想做到的事:快、準、能預判用戶的意圖。

所以別看 Sorter 好像只是個排序工具,它實際上是讓搜尋系統「從資料堆裡找答案」的起點,一旦這邊基礎打穩,後面所有的排名運算、語意理解、生成回答才有空間發揮。

Sorter 排序前 vs 排序後:一個詞彙排序的例子

排序前(由 Indexer 輸出的原始順序,依據 docID)

- 台北 → wordID:789

- 美食 → wordID:123

- 小吃 → wordID:456

這時候資料是照「哪個網頁(docID)抓到什麼詞」的順序來排的。重點在於「這篇網頁有哪些內容」,適合做全文檢索、或是網頁內部分析,但不適合用來搜尋。

| 詞彙 | wordID(詞彙編號) |

| 台北 | 789 |

| 美食 | 123 |

| 小吃 | 456 |

排序後(由 Sorter 重新排序,依據 wordID)

- 美食 → wordID:123

- 小吃 → wordID:456

- 台北 → wordID:789

這樣一排,變成「我要查美食,系統直接跳到 wordID 123 對應的網頁清單」,不必整份資料翻到底。這就像圖書館改用條碼分類一樣,搜尋效率直接升級。

| 詞彙 | wordID(詞彙編號) |

| 美食 | 123 |

| 小吃 | 456 |

| 台北 | 789 |

網址解析器:URL Resolver,把每條連結都變成可追蹤的路徑圖

URL Resolver 會去讀取 Anchors 檔案。在正式處理前,它的第一個硬仗,其實是做「URL 正規化(Canonicalization)」。白話講,就是要把 http://、https://www、結尾有沒有 / 這種長得有點像但其實是同一頁的網址,全部統一成一個「官方版本」,這步很重要,因為它能避免我們在後續排名中,把同樣的內容當成不同頁面來處理,浪費資源又影響用戶體驗。

整理乾淨後,它才會開始將相對 URL(連結縮寫)轉換為絕對 URL(完整的連結),再把絕對 URL 轉為 docID 的編號。這裡的目的是要方便快速搜尋到這個網址,而且 URL Resolver 還會把帶有超連結的文字建立索引。然後,URL Resolver 把 Anchors 檔案裡面的網址翻譯成 docID(文件的編號)之後,就會把資料存到 Doc Index。

同時,URL Resolver 也會將 Anchors 檔案裡網頁之間的關係儲存在 Links 資料庫,而這將是 PageRank 計算的基礎。沒錯,這個 Links 資料庫就是我們計算 PageRank 的基礎,這點到今天都沒變。PageRank 是我們理解網路「民主投票」結構的基石。

但是,2025 年的網路環境早就不是單純靠「誰連誰」可以解釋的了。內容農場、買賣連結、亂丟社群貼文的情況太多,所以光看「票數」已經不夠,我們還得看「投票者是誰」、這票是怎麼投出來的、連結文字上下文在講什麼。

因此,URL Resolver 在解析連結關係時,早就不只看「誰連到誰」。它會進一步利用語言模型去分析連結前後的上下文,判斷這個連結是真心推薦、隨便引用、還是廣告。換句話說,一個在政府網站或研究報告裡被引用的連結,跟一個塞在論壇簽名檔、購物網評價區的連結,它們在搜尋引擎眼中是完全不同等級的「信任指標」。

另外一個升級,是現在不只看「連結存在」,還會看「這個連結有沒有人點、點完有沒有回來原頁、點進去停多久」。這些互動資料會被送進 Links 資料庫中,當作連結品質的一部分,進一步強化 PageRank 的可信度。從早年的「被誰連」演變到現在的「這連結到底有沒有用」,整個連結的價值評分機制已經不只是算數學,是在理解行為。

PageRank 演算法一旦計算完成每個網頁的重要性分數後,就會把結果提供給 Searcher,Searcher 再根據 PageRank 對搜尋結果進行排序。

所以,最後計算完成,提供給 Searcher 的,早就不只是一個單純的 PageRank 分數了。它更像是一份完整的「網站信譽報告」,裡面包含了經典的 PageRank、信任度分數(Trust Score)、主題權威性、使用者互動品質,以及各種垃圾訊息嫌疑指標。

這樣,最終 Searcher 在排序時,才能做出更全面、更貼近真實世界權威性的判斷,確保用戶看到的,是值得信賴的優質結果。

從產品經理的角度看,這整段流程關鍵就在於:讓系統不只是知道「連到哪」,而是真的能判斷「哪個連結值得信任」。搜尋引擎要有能力辨別推薦背後的動機,才能在這個充滿操作與假內容的網路世界裡,持續給出真正有價值的答案。

黑盒子一般的排名因素:各種演算法的加入

在 1998 年時,PageRank 是一種主要用來判斷排名重要性的演算法,主用於評估網頁的重要性(在 1998 年時的網路內容沒有那麼多元、複雜),它主要根據網頁被其他頁面連結的數量和質量來計算。你說的完全正確,PageRank 解決了「哪些網頁在網路上最重要」這個問題。但在 2000 年後,產品要解決的問題變成了「用戶打的這串字,到底是什麼意思?」以及「在數十億個相關的頁面中,哪一個才是最佳解答?」光靠連結投票,已經解不了這個題了。

這就開啟了 Google 長達二十多年的「演算法軍備競賽」。從最早處理新詞彙的 AI 系統 RankBrain,到真正搞懂句子上下文的 BERT,再到 2025 年能跨模態理解圖片和影片內容的語言模型。與此同時,Google 也推出了「實用內容系統(Helpful Content System)」,並公開其評分指南核心 E-E-A-T(經驗、專業、權威、可信)。這套標準就像是其排名系統的「憲法」,確保系統獎勵的是為「人」寫的優質內容,而不是為機器寫的 SEO 文章。

所以,沒錯,但目前有著多到爆的排名因素。之所以感覺像個「黑盒子」,原因很單純:防堵作弊。如果 Google 公布完整演算法,那作弊者隔天就能把垃圾內容推到第一頁,這對用戶是毀滅性的體驗。

其中包括你正在使用的 Chrome 瀏覽器操作網頁內容、廣告投放後讓網站增加點擊流量等等,都可能會有影響……這點可以說得更精準些:搜尋引擎確實會看整體的「互動訊號」來判斷結果的好壞。例如,用戶點進一個結果後,是心滿意足地離開,還是馬上跳回 Google 繼續找?這就是一個強力的品質訊號。但這不是單純的「點擊量競賽」,而是數百個訊號中的一環,跟廣告投放也沒有直接關係。最終目的,是獎勵能真正「解決用戶問題」的頁面,而不只是騙到點擊的頁面。

到了 2025 年,整個排序邏輯早就從「靠連結投票」進化成「全方位行為模型」,真正進入黑盒時代。這個系統已經不是一條公式或幾個因子可以解釋的,而是由數百個傳統訊號 + AI 模型決策網絡組成的多層評分系統。

作為產品經理,我會把這套系統看成是:它試著模擬一位專業知識豐富的編輯,在幾毫秒內看完幾百篇文章,然後挑出最值得推薦的一篇給你。

這背後的每個演算法與子系統,都是在回答一個問題:「這頁能不能把用戶的問題好好解決?」以下是目前 Google 內部已知或歷史上重要的排序模組,根據功能分成幾類,我用產品經理的語言來翻譯它們到底在幹嘛:

核心:查詢與內容理解(Query & Content Understanding)

這些是系統的大腦,負責搞懂「用戶到底想問什麼?」以及「網頁到底在講什麼?」

- BERT(Bidirectional Encoder Representations from Transformers)

Google 終於能看懂句子裡的介係詞,像「到」、「的」、「給」這類看起來很小但影響很大的詞。它幫助系統分清楚「台北到高雄」跟「高雄到台北」是兩件事。 - MUM(Multitask Unified Model)

BERT 的超進化版。它可以同時理解多語言、圖片、影片等資訊。例如你拍一雙登山鞋,然後問「這雙適合爬玉山嗎?」MUM 會理解圖片與中文問題背後的需求。 - RankBrain

Google 第一個大規模使用的 AI 模型,專門處理從沒看過的新查詢。遇到陌生關鍵字時,它會去猜使用者可能是在問什麼,再丟出相似問題的結果。 - Hummingbird(蜂鳥)

早期語意搜尋的基礎,讓 Google 開始跳脫關鍵字比對,轉向理解整句話的意思。你可以把它當成 RankBrain 和 BERT 的基底骨架。

品質與權威性評估(Quality & Authority Assessment)

這些像品管人員,負責判斷網頁是不是值得信任、是不是寫給真人看的。

- PageRank

經典開山祖師爺,用「連結等於投票」的邏輯來判斷權威性。雖然現在只是眾多訊號之一,但「被誰推薦」仍然很重要。 - Helpful Content System

近年核心更新,目標是找出「給人用的」原創內容,反制農場文、生成文、無腦塞關鍵字的東西。 - Reviews System

專門評估產品、地點、服務類的評論內容。系統會分辨這是不是個人經驗,還是只是把官網資料抄一遍。 - E-E-A-T(Experience, Expertise, Authoritativeness, Trustworthiness)

這是 Google 的內容品質憲法。不是演算法,而是訓練 AI 怎麼判斷品質的準則。你可以把它當作整個系統的道德底線。

反作弊與降級系統(Spam & Demotion Systems)

這些像警察單位,專門抓作弊或低品質內容。

- Panda

打擊「低品質內容」,像是內容農場、重複抄襲的垃圾站。 - Penguin

打擊垃圾連結,比如買來的連結、假外鏈灌流量。 - SpamBrain

目前還在服役的 AI 系統,專門識別作弊手法與釣魚網站。 - Pirate Update

處理侵犯版權的內容,一旦被 DMCA 投訴過多,網站排名會被狠狠砍。

特定場景與體驗系統(Specific Context & UX Systems)

這些是針對特定裝置與場景的體驗調整。

- Pigeon

處理「在地搜尋」,像是你人在台北搜尋「修手機」,它會優先推你附近的店。 - Mobile-Friendly Update

網頁在手機上排版爛、字太小?會直接被降級。

總結來說,Google 排名系統,就是一套 由上百種訊號與 AI 模型組成的決策引擎,它不再只靠幾個演算法,而是動態評估內容是否對使用者「有幫助、有解釋、有可信度」。這才是現在這個黑盒子真正關心的核心——用戶價值(User Value)。

搜尋器 Searcher:如何讀懂你想找什麼,還幫你挑好答案

Searcher 的主要用途,是處理用戶的搜尋需求,並利用已建立的索引找到並回傳相關的搜尋結果。

Searcher 首先會先接收用戶輸入的搜尋需求(一個或多個關鍵字),接著,它會分析這些搜尋需求。這個「分析」過程在 2025 年極其複雜,Searcher 會先用語言模型去理解用戶的「真實意圖」。例如,當你輸入「蘋果 股價」,系統會立刻識別出「蘋果」是實體 Apple Inc.,而「股價」是查詢意圖,然後可能在內部將查詢改寫成更精準的指令。接著它才會將搜尋中的關鍵字轉換成詞彙表(Lexicon)中對應的 wordID,再利用反向索引(以及我們前面提到的向量索引)找到含有這筆 wordID 的 HTML 內容。這個階段,它會先快速抓取數千個可能的候選結果。

這個過程就像是從一個超大圖書館裡,用雷達掃出一堆可能相關的書頁,然後再挑出真正值得看的那幾頁。搜尋器會先用 PageRank 這類比較輕量的信號,對這些候選結果做第一輪的快速篩選。PageRank 的基本邏輯是:越多高品質網站連到這頁,代表它可能越值得信賴。篩完之後,再交由高成本的 AI 排名模型做精細的二次排序。這時不只看頁面內容,更會考慮用戶的搜尋脈絡,例如使用者的語言、所在地區、裝置類型,甚至是目前全球正在熱搜什麼。這一切的目的,就是要把「當下最有幫助」的答案排到最前面,這才是產品經理最該在意的排序邏輯——不是資料最全,而是最有用。

而這一切最後的呈現,也不是只是丟出一排連結這麼簡單。搜尋結果頁(Search Engine Results Page)其實是一個動態生成的介面。Searcher 根據你的查詢意圖,會組裝出不同的模組。例如查人物,就會跳出知識面板;查做法,就顯示教學影片的時間軸;查開店,就把地圖和店家資訊擺出來。甚至現在還加入了 Gemini AI 的回答區塊,直接總結重點讓你不用點進網站。

也就是說,最後你看到的不是搜尋結果,而是一份「用戶需求解決方案」。這份解法可能來自網站、也可能是影片、PDF、甚至是 AI 回答。而所有這些呈現與排序,都是 Searcher 串起來的產品邏輯。從產品經理的角度來說,這不只是滿足使用者查詢,更是把資訊消化後「重新包裝成可用的答案」,這才是 Google Search 真正的價值。

本篇參考文章與相關論文

- Anchor Tag Indexing in a Web Crawler System

Dean, J. A., Ghemawat, S., & Thambidorai, G. (n.d.). Anchor tag indexing in a web crawler system. Google Inc. - Systems and Methods for Generating Statistics from Search Engine Query Logs

Dean, J. A., Ghemawat, S., & Thambidorai, G. (n.d.). Systems and methods for generating statistics from search engine query logs. Google Inc. - Duplicate Document Detection in a Web Crawler System

Dean, J. A., Ghemawat, S., & Thambidorai, G. (n.d.). Duplicate document detection in a web crawler system. Google Inc. - Document Scoring Based on Query Analysis

Dean, J. A., Ghemawat, S., & Thambidorai, G. (n.d.). Document scoring based on query analysis. Google Inc. - Efficient Indexing of Documents with Similar Content

Dean, J. A., Ghemawat, S., & Thambidorai, G. (2013). Efficient indexing of documents with similar content (U.S. Patent No. 8,554,561 B2). United States Patent and Trademark Office. - What is 304 Not Modified Response?

- Our new search index: Caffeine

- Secrets from the Algorithm: Google Search’s Internal Engineering Documentation Has Leaked

常見問題

總結來說,身為一個網站經營者或內容創作者,我最該關注的 Google 排名核心是什麼?

核心只有一個:創造能真正解決用戶問題的「高品質、可信、原創」內容。 技術面的 SEO 依然重要,但 Google 的所有系統(尤其是實用內容系統與 E-E-A-T 原則)都在獎勵那些展現出真實經驗 (Experience)、專業知識 (Expertise)、權威性 (Authoritativeness) 和可信度 (Trustworthiness) 的內容。與其猜測演算法,不如專注為你的目標用戶提供全網最好的答案。

所以,花錢買 Google 廣告 (Google Ads) 到底能不能提升我的自然搜尋排名?

不能,這是兩套完全獨立的系統。Google Ads 的競價排名和自然搜尋排名是分開計算的,付費廣告不會直接拉高你的自然排名。但從產品策略角度看,好的廣告可能會帶來品牌曝光和用戶流量,如果這些用戶在你的網站上獲得良好體驗,可能會間接產生一些正面信號(如品牌字搜尋、用戶回訪),但這不是直接的因果關係。

為什麼我和朋友用同一個關鍵字搜尋,看到的結果排名不一樣?

這主要是因為「搜尋脈絡 (Context)」的影響。Google Searcher 在排序時,會考慮多種個人化與即時因素,主要包含:

地理位置: 你們的所在地不同,本地搜尋結果會不一樣。

搜尋紀錄: Google 會參考你過去的搜尋習慣,判斷你可能對哪類資訊更感興趣。

語言設定: 你們使用的介面語言或偏好語言不同。

裝置類型: 手機和電腦看到的結果頁面(SERP)佈局和排名可能不同。

文中提到 Chrome 的使用者行為數據會影響爬取預算,這是否代表 Google 正在監控我的一切行為?

這是一個關於隱私的好問題。Google 官方的說法是,他們使用的是「匿名的、匯總的 (anonymized and aggregated)」數據來理解網頁的熱門程度與品質,而不是針對「某個特定使用者」的行為來進行排名。例如,系統看到的是「有 10,000 個匿名用戶點進 A 頁面後很快就跳出了」,而不是「張三點進 A 頁面後跳出了」。這些匯總數據被當作一個強力的品質信號,來判斷一個頁面是否真的受歡迎和實用。

隨著 Gemini AI 整合進搜尋,未來傳統的「10個藍色連結」會消失嗎?

這絕對是未來幾年最大的趨勢。傳統連結不會完全消失,但它們的角色正在改變。

AI 概覽 (AI Overviews) 會處理更多「直接問答」的需求: 對於事實型、總結型的查詢,AI 會直接在最上方生成答案,用戶可能就不需要點擊連結。

傳統連結轉為「佐證」與「深度探索」的角色: 對於需要深度研究、多方比較、或驗證信譽的主題,用戶依然會需要點擊進入原始網頁。AI 概覽也會附上來源連結,讓這些高品質網站成為 AI 回答的「信譽背書」。 簡單說,未來搜尋結果會更像一份「解決方案」,而不是一份「網址清單」。

若想深入了解 SEO 基礎概念,歡迎參考我們的完整指南:SEO是什麼?搜尋引擎最佳化(SEO) 入門指南:基本概念